LLM Leaderboard 사이트 모음

by CoriLLM 모델들 중 태스크별로 어떤 모델의 성능이 좋은지 한 눈에 볼 수 있는 사이트들을 소개한다.

1. Aider

- aider.chat에서 사용하는 코딩 어시스턴트 모델들의 벤치마크

- 주로 code editing, refactoring, bug fixing 등 실제 Git 코드베이스에 대한 조작 테스트를 다룸

- 평가 기준은 PR 자동 생성, 코드 이해력, 편집 능력 등이 있음

- https://aider.chat/docs/leaderboards

* 실제 사용 환경 (Git 기반 코드 편집)에 가까운 테스트 환경이지만, 일반적인 알고리즘 문제 해결 능력과는 다소 거리가 있고, 범용적이기 보다는 aider.chat의 사용 사례 위주이다.

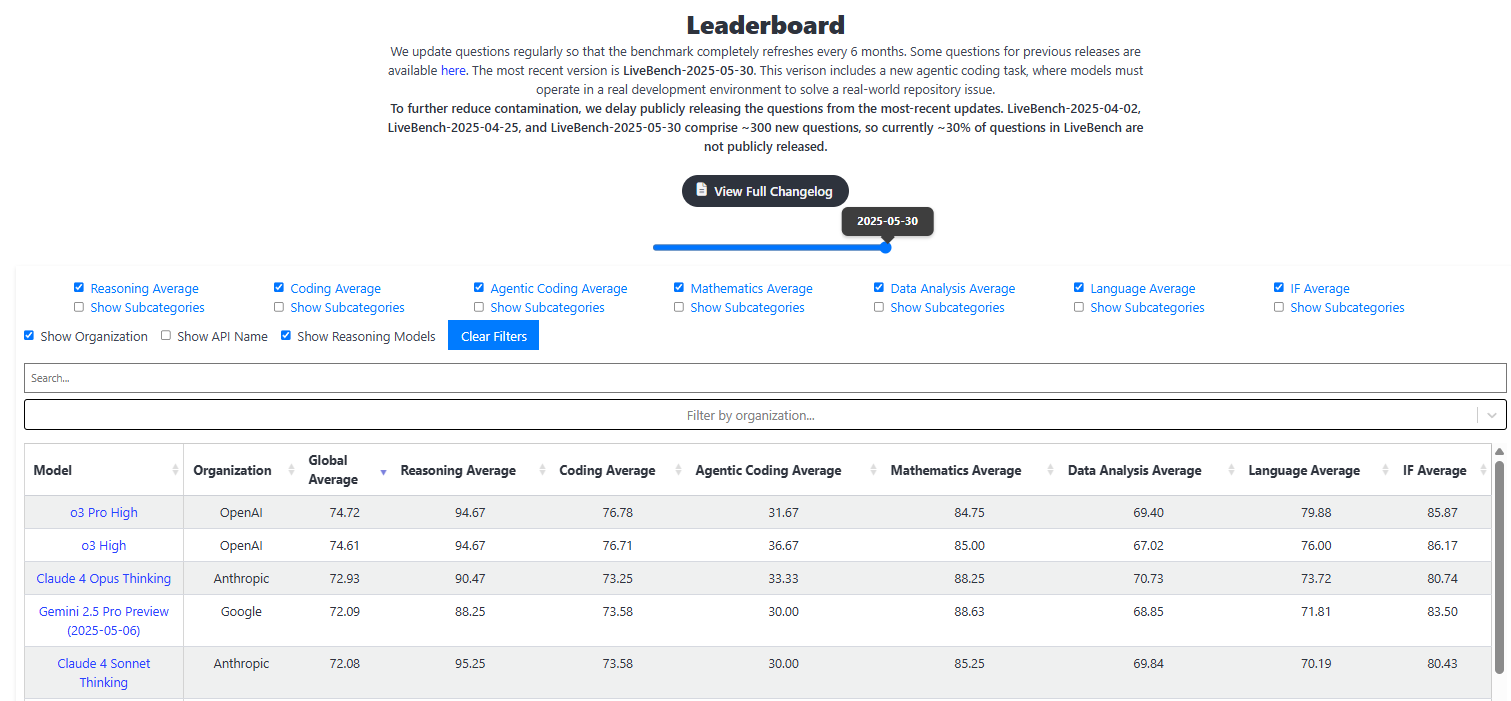

2. LiveBench

- 자동화된 실시간 벤치마크 플랫폼

- 다양한 코드 문제 (Python 위주)를 다양한 모델에게 실시간으로 물어봄.

- 문제 난이도, 실행 결과, 정확도 등을 기반으로 점수 부여

- 코딩 능력 이외에도 추론 능력, 언어 능력 등 다방면으로 평가

- https://livebench.ai/#/

* 실행 결과를 직접 확인할 수 있고, 객관적인 테스트 결과 기반 (컴파일, 실행 여부 포함)이기 때문에 신뢰성이 있다는 장점 존재. 하지만 일부 최신 모델 반영이 다소 늦을 수 있고 (현재 o1 반영 x), 다양한 언어나 도메인 커버리지는 제한적일 수 있다.

3. HuggingFace Leaderboard

- 대표적인 오픈소스 LLM 벤치마크

- 다양한 평가지표 (IFEval, BBH, MATH, GPQA, MUSR 등) 사용

- 매주 모델 제출 가능, Hugging Face 모델 기준 자동 평가됨

- https://huggingface.co/spaces/open-llm-leaderboard/open_llm_leaderboard#/

* 오픈소스 모델 비교하려면 가장 먼저 참고해야 할 곳

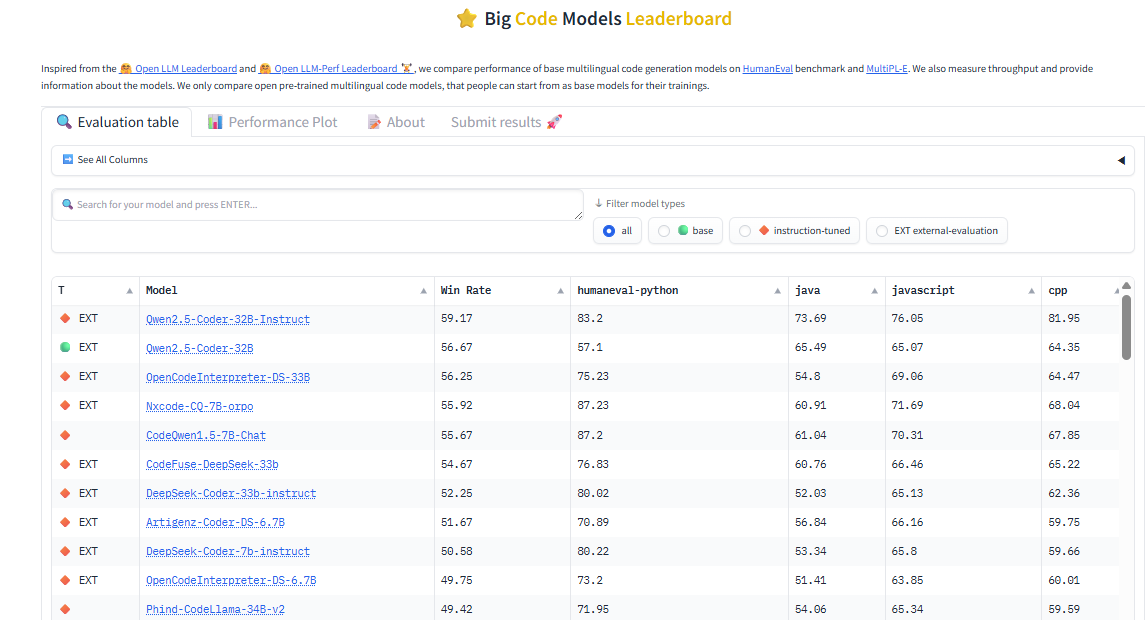

4. BigCode Models Leaderboard

- HumanEval을 확장한 새로운 벤치마크

- 다양한 프로그래밍 언어와 복잡한 코드 작성 능력을 평가

- https://huggingface.co/spaces/bigcode/bigcode-models-leaderboard

5. Chatbot Arena (lmsys.org)

- LMSYS (Vicuna 만든 연구팀)

- 익명 대결 기반 평가 (사람들이 A vs B 채팅 보고 투표)

- Battle 방식으로 인해, 사용자 선호도 기반 순위 생성 가능

- https://lmarena.ai/leaderboard

* 주관적이지만 실제 사용감 비교 성능을 알 수 있고, GPT vs 오픈소스 모델 성능 비교에도 좋다. 다음과 같이, 챗봇과 대화하며 A 모델과 B 모델의 응답 중 어느것이 더 좋은지, 혹은 동점인지 등을 평가하는 방식이 재밌게 다가왔다.

6. Vellum Leaderboard

- 2024년 4월 이후에 출시된 최신 모델들만 다룬 리더보드

- 신뢰도 높은 벤치마크만 선별 적용 (MMLU 같은 거의 모든 모델들이 높은 성능을 보인 벤치마크 제외)

- 실제 업무 적용 테스트 (Vellum의 Eval 기능 사용) 가능

- https://www.vellum.ai/llm-leaderboard

'AI' 카테고리의 다른 글

| LLMOps 살펴보기, 2일차 (0) | 2025.09.16 |

|---|---|

| LLMOps 살펴보기, 1일차 (0) | 2025.09.03 |

| MCP ? Cursor AI로 쉽게 사용해보자 (4) | 2025.05.21 |

| Ollama를 활용한 Image to Text (Vision model 성능 비교) (4) | 2025.02.19 |

| Ollama 사용 설정하기 (2) | 2025.02.18 |

블로그의 정보

코딩하는 오리

Cori